EML4U

EML4U website

EML4U: Erklärbares Maschinelles Lernen für interaktive episodische Updates von Modellen

Kurzvorstellung

Mit Maschinellem Lernen (ML) lassen sich anhand von Daten komplexe Zusammenhänge modellieren. Somit können aufwändige und oft grob vereinfachte mathematische Modellierungen bestimmter Gegebenheiten umgangen werden. Außerdem eröffnet sich zudem eine neuartige Funktionalität: ML-Modelle können datengetrieben an geänderte Anforderungen und Bedingungen angepasst werden. Um eine regelmäßige Anpassung zu erreichen, werden Daten während des Gebrauchs eines Modells gesammelt und das Modell unter Berücksichtigung dieser Information neu trainiert, es findet also ein episodisches Update des ML-Modells statt.

Publikationen

- Artelt, André, Fabian Hinder, Valerie Vaquet, Robert Feldhans, and Barbara Hammer. 2022. “Contrasting Explanations for Understanding and Regularizing Model Adaptations.” Neural Processing Letters. https://doi.org/10.1007/s11063-022-10826-5.

- Bondarenko, Alexander, Magdalena Wolska, Stefan Heindorf, Lukas Blübaum, Axel-Cyrille Ngonga Ngomo, Benno Stein, Pavel Braslavski, Matthias Hagen, and Martin Potthast. 2022. “CausalQA: A Benchmark for Causal Question Answering.” In COLING, 3296–3308. https://aclanthology.org/2022.coling-1.291.pdf.

- Feldhans, Robert, and Barbara Hammer. (to be published). “Drift Explanation with Difference Accentuation.”

- Feldhans, Robert, Adrian Wilke, Stefan Heindorf, Mohammad Hossein Shaker, Barbara Hammer, Axel-Cyrille Ngonga Ngomo, and Eyke Hüllermeier. 2021. “Drift Detection in Text Data with Document Embeddings.” In Intelligent Data Engineering and Automated Learning – IDEAL 2021, edited by Hujun Yin, David Camacho, Peter Tino, Richard Allmendinger, Antonio J. Tallón-Ballesteros, Ke Tang, Sung-Bae Cho, Paulo Novais, and Susana Nascimento, 107–18. Cham: Springer International Publishing. https://doi.org/10.1007/978-3-030-91608-4_11.

- Schröder, Sarah, Alexander Schulz, Philip Kenneweg, Robert Feldhans, Fabian Hinder, and Barbara Hammer. 2022. “The SAME Score: Improved Cosine Based Bias Score for Word Embeddings.” arXiv. https://doi.org/10.48550/ARXIV.2203.14603.

- Shaker, Mohammad Hossein, and Eyke Hüllermeier. 2021. “Ensemble-Based Uncertainty Quantification: Bayesian Versus Credal Inference.” In Proceedings - 31. Workshop Computational Intelligence : Berlin, 25. - 26. November 2021, edited by Horst Schulte, Frank Hoffmann, and Ralf Mikut. KIT Scientific Publishing. https://arxiv.org/abs/2107.10384.

- Wilke, Adrian, Stefan Heindorf, Robert Feldhans, Barbara Hammer, and Axel-Cyrille Ngonga Ngomo. (to be published). “Explaining Drift in Text Data with Document Embeddings.” https://t1p.de/explain-drift.

- Wilke, Adrian, and Axel-Cyrille Ngonga Ngomo. 2023. “LauNuts: A Knowledge Graph to Identify and Compare Geographic Regions in the European Union.” In The Semantic Web. https://papers.dice-research.org/2023/ESWC_LauNuts/Wilke-2023-LauNuts-KnowledgeGraph-EuropeanUnion-public.pdf.

- Zahera, Hamada M., Rricha Jalota, Mohamed Ahmed Sherif, and Axel-Cyrille Ngonga Ngomo. 2021. “I-AID: Identifying Actionable Information from Disaster-Related Tweets.” IEEE Access 9: 118861–70. https://doi.org/10.1109/ACCESS.2021.3107812.

- Zahera, Hamada M., Daniel Vollmers, Mohamed Ahmed Sherif, and Axel-Cyrille Ngonga Ngomo. 2022. “MultPAX: Keyphrase Extraction Using Language Models and Knowledge Graphs.” In ISWC. Springer. https://papers.dice-research.org/2022/ISWC-MultPAX/public.pdf.

Software

Veranstaltungen

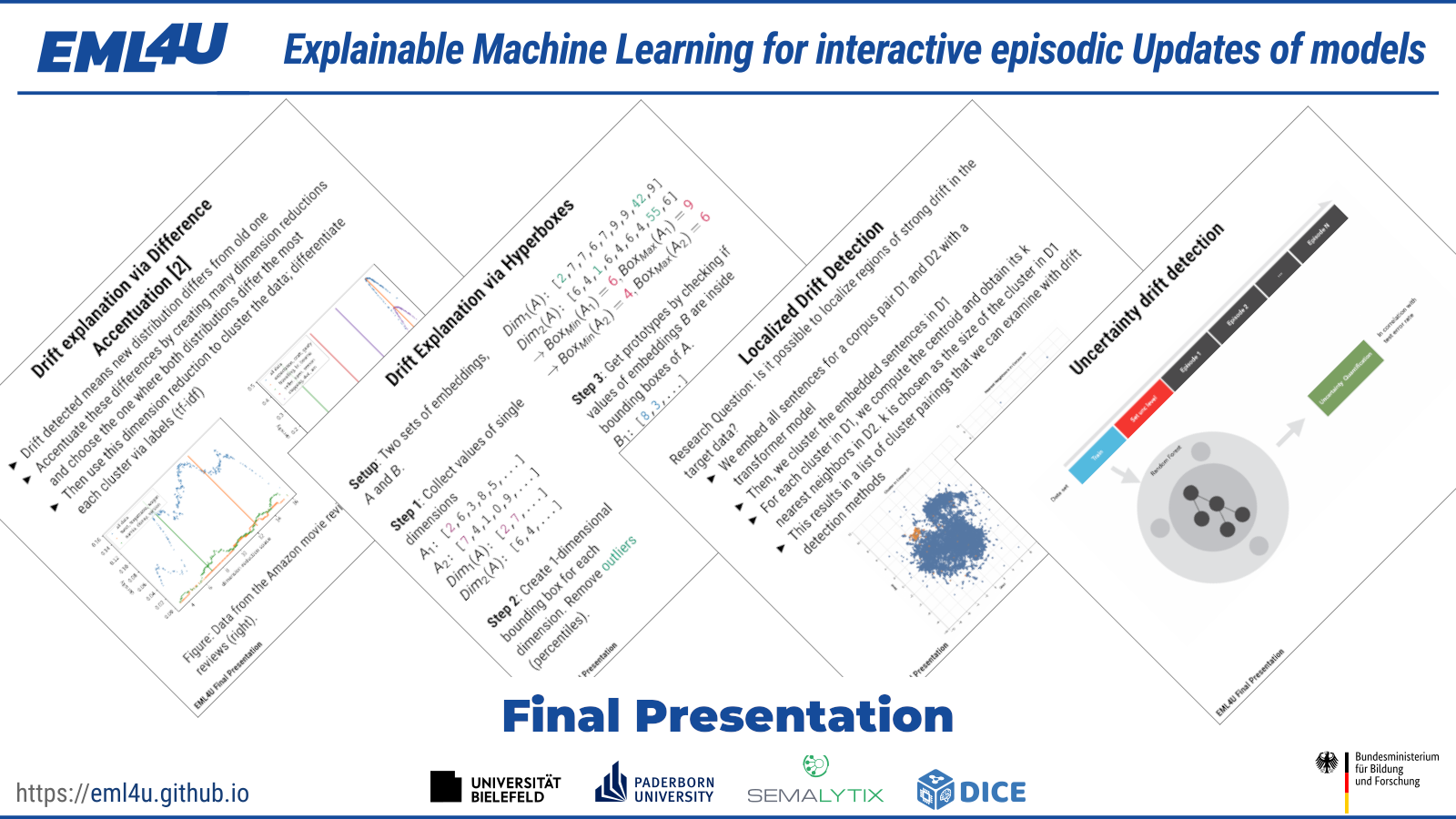

Final Presentation (2022)

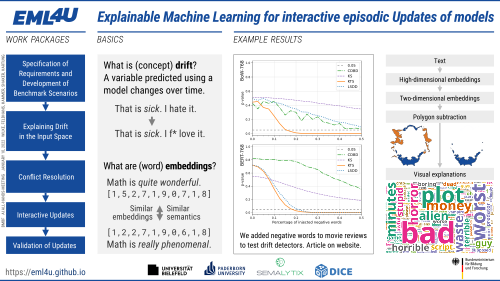

All-Hands-Meeting of the BMBF-funded AI Research Projects (2022)

Standort: Session 3, Raum D, Poster D45, 13:00 Uhr, AI Explainability and Transparency.

Partner

- Universität Bielefeld Institut für Kognition und Robotik (CoR-Lab) (Koordination)

- Universität Paderborn - Arbeitsgruppe Data Science (DICE)

- Universität Paderborn - Arbeitsgruppe Intelligente Systeme und Maschinelles Lernen (ISML),

LMU München - Arbeitsgruppe Künstliche Intelligenz und Maschinelles Lernen (KIML, Prof. Hüllermeier) - Semalytix GmbH

Förderung

Gefördert vom Bundesministerium für Bildung und Forschung (BMBF) / DLR Projektträger im Bereich Erklärbarkeit und Transparenz von KI.